Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

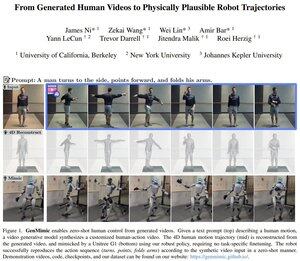

Est-ce le premier article de Yann LeCun après avoir quitté Meta ?

Il démontre comment des robots humanoïdes peuvent imiter des actions à partir de vidéos générées par l'IA, qui sont souvent trop bruyantes pour une imitation directe.

Le système élève la vidéo en points clés 3D et utilise ensuite une politique consciente de la physique pour exécuter les mouvements, permettant un contrôle sans apprentissage préalable.

Ils ont implémenté cela sur le robot humanoïde Unitree G1.

Meilleurs

Classement

Favoris